Aktywne Wpisy

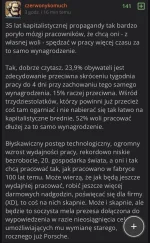

USSCallisto +28

Zawsze pod takimi wpisami zastanawia mnie jedno - dlaczego zwolennicy pomysłów takich jak czterodniowego tygodnia pracy przy zachowaniu wypłaty czy równego dzielenia zysków firmy między właścicielem, a pracownikami (zysków, ale strat już oczywiście nie) nigdy, przenigdy nie założą biznesów, w których udowodniliby jak piękne są te założenia?

Tak, wiem, że czterodniowy tydzień pracy jest testowany w różnych miejscach na świecie i przynosi pozytywne efekty w niektórych branżach. Właśnie o to chodzi, że

Tak, wiem, że czterodniowy tydzień pracy jest testowany w różnych miejscach na świecie i przynosi pozytywne efekty w niektórych branżach. Właśnie o to chodzi, że

źródło: IMG_6912

Pobierz

KolorowychSnow +173

Kto w Amazonie wpadł na pomysł, żeby dodać do oferty Sarnie Żniwo? XD

#walaszek #sarniezniwo #amazonprime #kapitanbomba #gitprodukcja

#walaszek #sarniezniwo #amazonprime #kapitanbomba #gitprodukcja

źródło: 1000001773

Pobierz

Ciekawi mnie to, jak OpenAI odpowie na oczekiwania użytkowników, którzy chcą coraz lepszych modeli w każdej kolejnej iteracji. Nie chodzi nawet o to, że model muszą być "tylko" lepsze. Muszą one być "wyraźnie" lepsze. Tzn, musi to być zauważalne przez zwykłego użytkownika. Płaci on przecież za subskrypcję i wymaga, by zadanie, które do tej pory, przy modelu gpt-x rozwiązywane było np. z jakością j, w modelu gpt-x+1 rozwiązywane było z jakością j+1.

Skok jakościowy między gpt-2 a gpt-3 i gpt-3 a gpt-4 był ogromny, ale też relatywnie prosty do osiągnięcia (dla OpenAI). Tylko co dalej? Moc obliczeniowa jest skończona. Dane treningowe najprawdopodobniej nie będą już jakości podobnej do tej, która stanowiła 100% zbioru treningowego gpt-4 (prawa autorskie, rosnąca świadomość tego, że firmy używają danych "za darmo" oraz rosnąca ilość śmieci produkowanych przez llmy). Do tego dochodzą nowe papery, jak ostatni od MS, wskazujące wbrew temu, co firmy tech chcą, żebyśmy wierzyli, że llmy na ten moment nie wskazują możliwości uogólniania poza dane treningowe https://arxiv.org/abs/2311.00871.

Myślę, że OpenAI będzie szło bardziej w stronę specjalizacji i modeli szytych na miarę, niż coraz większych llmów. Plus będą wsadzać swoje modele gdzie tylko się da. I tak przez pewien czas. Aż do przełomu.

@JamesJoyce: Niestety w życiu, jak i w hi-tech jest tak ze po gorce następuje stagnacja, dopóki nie pojawi się następna disruptive technology.

Co jest do wszystkiego to jest do niczego - ale jak stworzysz podobny model wyuczony wyłącznie na np. instrukcjach do różnych samochodów i bazie części zamiennych, to może powstać świetne narzędzie dla serwisów samochodowych. Itp. itd. Sky is the limit -

W modelu gpt-x+1 wystarczy j . Byle nie było j-1 albo j-4 jak czasem się zdarza, bo średnio moze być lepszy ale w niektórych zagadnieniach dużo gorszy

no kurdebele nie wiem, nie wiem byku

tldr; wróżenie z fus(s)ów

@JamesJoyce: komputery kwantowe, kubity, mówi ci to coś? Krzemowe procesorki to żadna moc obliczeniowa, to jak deskorolka. Komputery kwantowe to jak samochód sportowy.

Więc samo dopracowanie komputera kwantowego zapewni większą moc obliczeniową i lepsze modele

@nad__czlowiek: U progu dopracowania komputera kwantowego to byliśmy jakieś 10 lat temu, ale jakoś wiele się przez ten czas nie zmieniło.