#programista15k #datascience #artificialintelligence #sztucznainteligencja

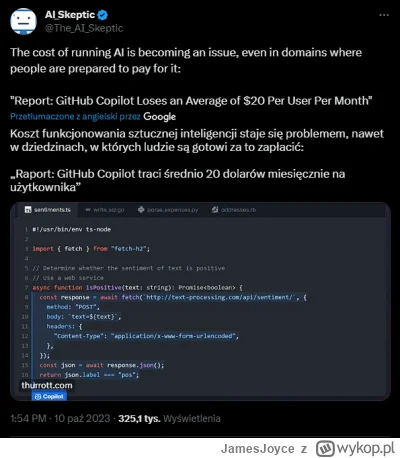

Ciekawe w jaki sposób Microsoft będzie redukował koszty, do momentu rozwoju AI, które będzie generowało większe przychody. Zarabiają na innych rzeczach, więc nie jest to pewnie jakiś wielki problem, ale jeśli rentowność nie zacznie rosnąć, może się nim stać. Ciekawe czy pójdą np. w reklamy, albo transfer kosztów obliczeniowych na klienta. Nie wiem jak to ostatnie mogłoby wyglądać.

Ciekawe w jaki sposób Microsoft będzie redukował koszty, do momentu rozwoju AI, które będzie generowało większe przychody. Zarabiają na innych rzeczach, więc nie jest to pewnie jakiś wielki problem, ale jeśli rentowność nie zacznie rosnąć, może się nim stać. Ciekawe czy pójdą np. w reklamy, albo transfer kosztów obliczeniowych na klienta. Nie wiem jak to ostatnie mogłoby wyglądać.

źródło: copilot

Pobierz

Wiadomo coś nt. BloombergGPT? Jakiś czas temu było głośno o tym projekcie, jest artykuł na arxivie i Medium, ale nie mogę znaleźć modelu do pobrania/

https://medium.com/codex/bloomberggpt-the-first-large-language-model-for-finance-61cc92075075