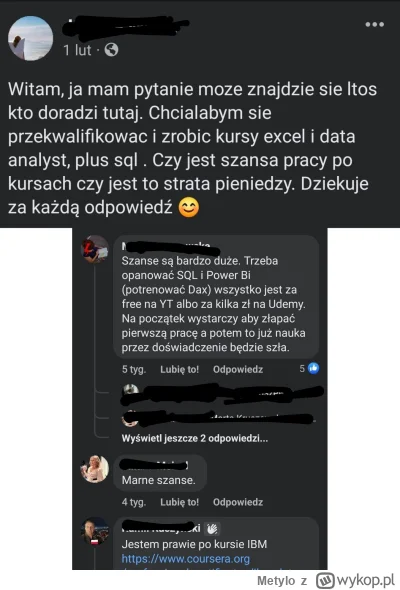

Cześć Mirki, proszę o radę.

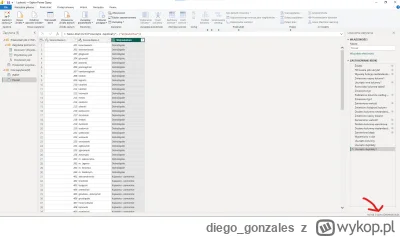

Obecnie jestem w trakcie studiów, kończę licencjat z ekonomii, jednak chciałbym swoją przyszłość związać z analizą danych. Pracuję w księgowości, lubię pracować z danymi stąd ta decyzja. Excela znam perfect, do tego trochę VBA, Power Query, SQL na poziomie basic ale wciąż się uczę, to samo Python, również szkolę się w Power BI. W moim mieście na uczelni prywatnej otworzyli nowy kierunek studiów podyplomowych "Analiza danych". Studia

Obecnie jestem w trakcie studiów, kończę licencjat z ekonomii, jednak chciałbym swoją przyszłość związać z analizą danych. Pracuję w księgowości, lubię pracować z danymi stąd ta decyzja. Excela znam perfect, do tego trochę VBA, Power Query, SQL na poziomie basic ale wciąż się uczę, to samo Python, również szkolę się w Power BI. W moim mieście na uczelni prywatnej otworzyli nowy kierunek studiów podyplomowych "Analiza danych". Studia

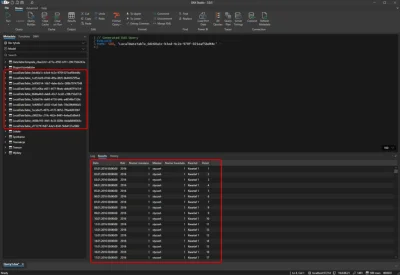

Dużo zależy od dojrzałości organizacji i działu BI w którym pracujesz oraz ważności samego narzędzia dla biznesu. Często jest tak, że firmy które nie wypracowały sobie jeszcze odpowiednich praktyk i procesów rozbijania narzędzi raportowych zostawiają ten temat samemu sobie i często kończy się tak, że CI/CD praktycznie nie istnieje. Ktoś zrobi rozwiązane na jednym środowisku, będzie je utrzymywał/rozbudowywał, przyjdą kolejni, przejmą zobaczą jak jest i tak zostawią.

Zwykle kolejnym krokiem,