- pascal256

Wszystko

Wszystkie

Archiwum

9

Sztuczna inteligencja potrafi stworzyć ultra realistyczne obrazy z prostego opisu. Mrówka Vader nie ma problemu.

z3

https://silencedevs.com/images/Czyli trochę o tym, jak cyberprzestępcy mogą wykorzystać uczenie maszynowe do popełniania wyrafinowanych przestępstw komputerowych.

z4

Obejrzyj, jak Alex Glow z Hackster.io rozpakowuje Arduino Nicla Vision! Malutki mikrokontroler na poziomie przemysłowym, który umożliwia uczenie maszynowe edge dzięki wbudowanej kamerze 2MP, mikrofonowi i czujnikom.

z

źródło: comment_16470407440jQFfM071pXNDpc4j2hWim.jpg

Pobierz

źródło: comment_1643015086BJd4e5eUvrKvm0cEp7YzBN.jpg

PobierzTreść została ukryta...

Treść została ukryta...

17

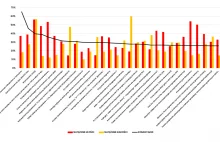

Z naszych analiz tytułów na Wykopie z okresu 1 listopad - 19 grudnia wynika, że najczęściej komentowane są jednak te, które są negatywne. Na 30 TOP komentowanych tytułów z w/w okresu w przypadku 19 mamy wyższe natężenie złości niż radości.

zWykop.pl