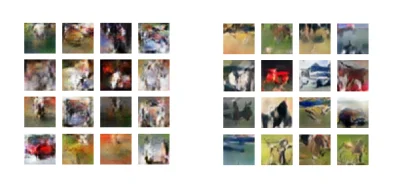

Jak odnowić stare filmy (powiedzmy nagrane w 240p) do 1080p? I jakich opcji użyć żeby wyglądało to naturalnie?

#edycjafilmow

#rendering

#grafikakomputerowa

#photoshop

#topaz

#odnawianiefilmow

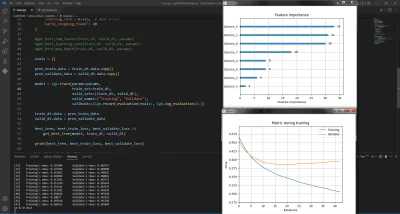

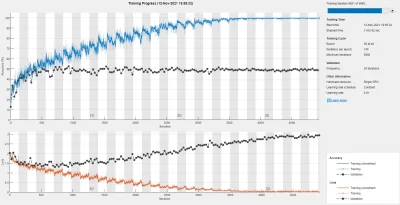

#siecineuronowe

#deeplearning

#neuralnetwork

#edycjafilmow

#rendering

#grafikakomputerowa

#photoshop

#topaz

#odnawianiefilmow

#siecineuronowe

#deeplearning

#neuralnetwork

https://helion.pl/ksiazki/sztinb.htm

https://helion.pl/ksiazki/delepy.htm

#sztucznainteligencja #machinelearning #deeplearning